Ya es habitual hablar de cómo las clínicas dentales están incorporando el uso de la tecnología en su práctica diaria en forma de digitalización. Y lo mucho que aún se puede avanzar en esa dirección. Sin embargo, no son las clínicas las únicas que se ven obligadas a innovar.

Hace apenas unos días, cualquier persona que trabaje en el sector digital ha podido experimentar la irrupción de ChatGPT, un sistema de chat basado en el modelo de lenguaje por Inteligencia Artificial GPT-3, capaz tanto de responder preguntas simples o complejas, como de hacer una presentación en PowerPoint y cualquier otra cosa imaginable entremedias.

Sin duda, la tecnología avanza a pasos agigantados.

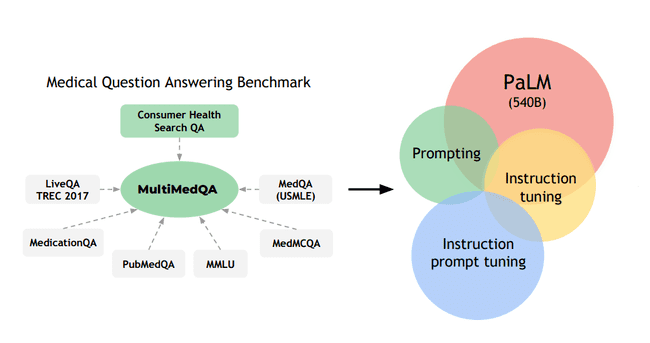

De hecho, las grandes tecnologías llevan tiempo experimentando con modelos de lenguaje grande (LLM) como el mencionado GPT-3 o PaLM, y Google no se iba a quedar atrás. Por eso, Google Research y DeepMind han introducido recientemente MultiMedQA, un LLM de código abierto para fines médicos.

Porque en la era de Internet, ya tan instaurado en nuestras vidas, no solo los pacientes, también los propios profesionales dentales hacen uso de Google y sus diferentes ramas (como Google Scholar o en español, Google Académico) para realizar búsquedas y consultar información, como se haría en cualquier biblioteca. Lo que hace imprescindible la tarea de encontrar maneras de recopilar y ofrecer esa información de forma fiable.

¿Qué hace exactamente MultiMedQA?

Aquí es donde MultiMedQA entra en juego, ya que, tal como explica Shritama Saha en un artículo para Analytics India Mag, lo que hace es combinar HealthSearchQA, – un nuevo conjunto de datos de respuesta libre de preguntas médicas buscadas online -, con seis conjuntos de datos de respuesta a preguntas abiertas que cubren exámenes médicos profesionales, investigación y consultas de usuarios.

Y lo hace de la siguiente manera:

- Por un lado, MultiMedQA proporciona conjuntos de datos para preguntas de opción múltiple y para respuestas más largas a preguntas planteadas por profesionales médicos y no profesionales.

- Por otro lado, el conjunto de datos de HealthsearchQA, que consta de 3375 preguntas frecuentes de los consumidores, utiliza diagnósticos médicos iniciales y sus síntomas relacionados para dar respuestas.

IA para luchar contra sesgos e información equivocada

No solo eso, Saha explica en su artículo que el modelo también incorpora una metodología para evaluar las respuestas del modelo humano en cuanto a factualidad, precisión, daño potencial y sesgo, comparándolo con otros LLM utilizados.

- Un grupo de médicos determinó que el 92,6% de las respuestas de Med-PaLM estaban a la altura de las respuestas generadas por los profesionales clínicos (92,9%), mientras que sólo el 61,9% de las respuestas largas de Flan-PaLM se consideraron conformes con el acuerdo científico.

- Además, el 5,8% de las respuestas de Med-PaLM se valoraron como potencialmente contribuyentes a consecuencias negativas, comparable a las respuestas generadas por los profesionales clínicos (6,5%), mientras que el en el caso de Flan-PaLM, lo fueron en un 29,7%.

Por lo que, el binomio MultiMedQA y PaLM introducido recientemente parece estar avanzando en la dirección correcta, al ofrecer los mejores resultados a través de su modelo de lenguaje grande.

Para más información: Large Language Models Encode Clinical Knowledge.